Техническая оптимизация сайта является базовой частью продвижения любого сайта. Нам нужно проинспектировать каждый укромный уголок сайта и в случае обнаружения проблем, исправить их.

Очень важно решать проблемы найденные на этапе аудита технических факторов полностью и без использования костылей, в противном случае с ростом сайта проблемы будут накапливаться как снежный ком.

- ЧПУ (Человекопонятный урл)

- Дубли страниц сайта

- Зеркала сайта

- Файл robots.txt

- Коды ответа сервера

- Ридеректы 301/302

- Код 304

- Код 404

- Карта сайта HTML/XML

- Страницы пагинации

- Битые ссылки

- Микроразметка

- Метатеги для индексации

- Канонические ссылки (rel=»canonical»)

- Перелинковка сайта

- Оптимизация кода сайта

- Оптимизация изображений

- Оптимизация файлов PDF

- Мобильная версия сайта

- Структура сайта

ЧПУ (Человекопонятный урл)

Данный адрес, как уже понятно из названия помогает пользователю уже по его адресу понять, что находится на самой странице.

Пример: https://diamast.ru/catalog/inektsionnye-nasosy/dlya-akrilatnyh-geley/

/catalog/ — говорит нам, что на данной странице мы найдем перечисление товаров или услуг.

/inektsionnye-nasosy/ — инъекционные насос

/dlya-akrilatnyh-geley/ — для акрилатных гелей

В итоге мы получаем: Каталог инъекционных насосов для акрилатных гелей.

Если вашу структуру нельзя прочитать по ссылке, то вам необходимо внедрить ЧПУ.

Дубли страниц сайта

Дублями считаются страницы которые отдают одинаковый контент, но располагаются на разных УРЛах.

Очень часто такие проблемы возникают из-за не совершенности систем управления сайтом (CMS) и настроек хостинга.

Вот распространенные ошибки:

- https://diamast.ru/catalog1/

- https://diamast.ru/catalog1

- https://www.diamast.ru/catalog1/

- http://diamast.ru/catalog1/

- http://diamast.ru/catalog1/index.html

Все эти страницы отдают одинаковый контент, но определяются поисковыми системами как разные страницы, так как они имеют разный адрес.

Нужно сделать так, чтобы к каждому уникальному контенту был всего один адрес. Добиться этого можно через 301 редиректы (перенаправления). В случае если ваши дубли уже были проиндексированы, необходимо убедиться, что все эти ссылки выдают корректный 404 код ответа сервера (Страница не найдена).

Зеркала сайта

Бывают ситуация когда для экспериментов над сайтом, возникает необходимость создать тестовую версию на поддомене https://test.diamast.ru и очень часто его забывают закрыть от индексации, что приводит к появлению двух разных (по мнению поисковых систем) сайтов выдающих одинаковый контент. Нетрудно догадаться, что кроме как пессимизации со стороны поисковиков, ждать не стоит.

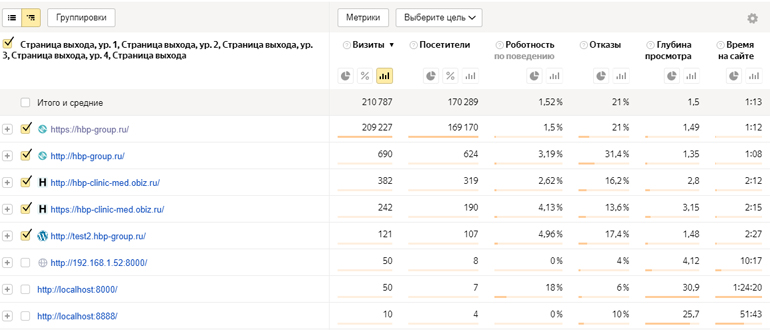

Для выявления данной проблемы мы можем воспользоваться Яндекс Метрикой и отчетом Содержание — Страницы входа. В идеале, мы должны увидеть всего один возможный домен сайта. В случае если мы видим следующую ситуацию, то нужно уже разбираться.

Так же можно скопировать несколько предложений с вашего сайта и вбить их в поисковую систему и посмотреть нашла ли поисковая система дубли.

Решать данную проблему можно и нужно через настройку 301 редиректа на основной (продвигаемый) сайт и закрытии от индексации других сайтов.

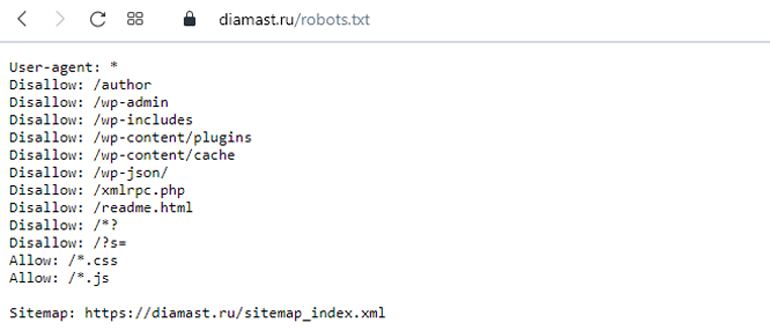

Файл robots.txt

Данный файл должен находится по адресу https://domain.ru/robots.txt. Данный файл является инструкцией для поисковых систем и говорит, какие страницы можно индексировать, а какие не стоит. Так же в данном файле указывается путь к карте сайт. Конечно же это не все возможности данного файла, более подробнее вы можете почитать в поддержке Яндекса и Гугла.

Коды ответа сервера

Для успешной индексации сайта необходимо чтобы продвигаемые страницы сайта отдавали 200 код ответа. Все что отличается от этого кода не попадает в индекс поисковых систем.

Ридеректы 301/302

Если они у вас есть на сайте, то стоит пересмотреть их необходимость и исправить. Предположим на вашей странице сайте, в контенте материала, есть ссылка на страницу, с которой идёт 301 перенаправление, но промежутки нам не нужны. Исправляем на странице доноре ссылку и делаем ее напрямую на конечную страницу.

Код 304

Данный позволяет проинформировать поисковые системы о внесенных изменениях на страницу. Предположим ваша страница А находится в индексе и вы не вносите в нее правки. Возникает вопрос: А зачем тогда тратить ресурсы поисковых систем и обрабатывать ее. Мы можем просто сообщить что 304 Not Modified (изменений нет) и в таком случае будет использоваться прошлая кэшированная версия сайта и ресурсы на обработку данных уйдут на другие страницы, в которых были внесены правки.

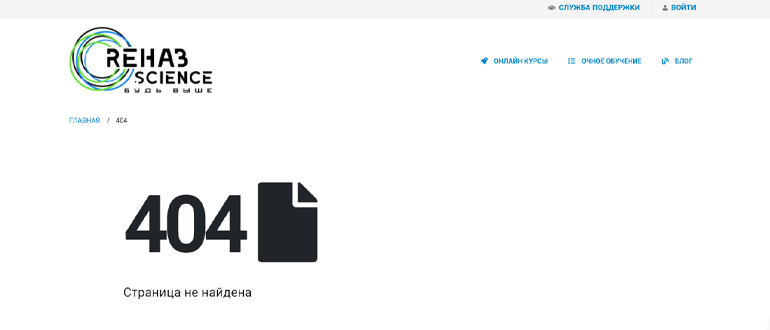

Код 404

Очень важно убедиться чтобы сайт отдавал корректный код 404. Бывают случаи, в контентной части написано: Страница не найдена, ошибка 404, но по факту страница отдает код 200 и начинает индексироваться, что приводит к появлению кучи мусорных страниц в индексе сайта и в таком случае рассчитывать на высокие позиции не приходится.

Карта сайта HTML/XML

HTML версия обычно располагается в подвале и должна служить пользователям для удобства навигации, но лучше всего продумать такую структуру сайта, чтобы пользователю было и так все просто и понятно. Дополнительно данная карта способна информировать поисковых роботов о всей ссылочной базе сайта.

XML карта сайта это «скрытая» от пользователей карта сайта и ее наличие необходимо только для поисковых систем. Обычно данная карта сайта располагается по адресу https://rehabscience.ru/sitemap.xml.

Страницы пагинации

Данный страницы нужны для нарезки длинных списков товаров. Предположим у вас в категории 100 товаров и получается очень тяжелая страница, которая потребует времени для загрузки и отрисовки браузером. Для того чтобы пользователь смог дозированно просматривать контент и нужна пагинация.

Битые ссылки

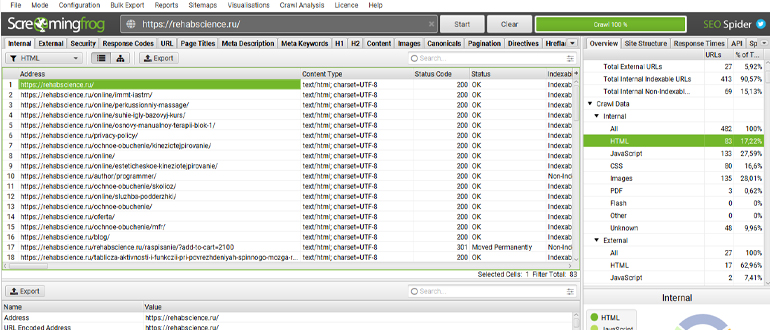

Сайт это объект динамический и требует регулярной инспекции. Вполне возможно, что какие-то страницы вы удалили, у другие страницы все еще продолжают на них ссылаться. Для этого вам необходимо спарсить сайт любыми пауками (краулерами) и изучить отчет с ошибками 404, ну и конечно исправить ссылки или удалить их совсем.

Микроразметка

Как уже понятно из названия, это специальная разметка кода позволяющая влиять на ваш сниппет, а значит и на CTR. Благодаря ей могут отображаться рейтинги товара в поисковой выдаче, изображения и прочие элементы.

Метатеги для индексации

К этим тегам относятся тэги:

- robots (Позволяет запретить индексацию страницы, но для того чтобы поисковик понял, что она запрещена, ему необходимо ее выгрузить, так что поберегите ресурсы и запретите индексацию данной странице в robots.txt)

- <!—noindex—> (Позволяет скрыть часть текста от индексации)

- rel=»nofollow» (Данный тэг рекомендует поисковикам не переходить по ссылки, но как показывает практика, если вы хотите совсем спрятать ссылку? то пока еще можете использовать java скрипты)

Канонические ссылки (rel=»canonical»)

Позволяет указать приоритетный контент. К примеру на нашем сайте есть страница категории где располагаются 20 товаров. Первые 10 товаров располагаются на первой странице, а оставшиеся на второй. Физически у нас получается две страницы с практически одинаковым контентом (за исключением товаров). Для этого у нужен данный тэг. Мы указываем в коде второй странице, что наиболее приоритетная страница под №1, переходить поисковик конечно будет на другие (вложенные) страницы, но не будет добавлять их в индекс.

Перелинковка сайта

В данном случае речь идет о внутренних ссылках (ссылки в пределах вашего сайта). Отличным примером перелинковки служат хлебные крошки. Они служат более целостному восприятию контента и позволяют перемещаться по всем разделам сайта. Одним словам нужны для удобства, но и позволяют перераспределять ссылочный вес на все страницы сайта.

Не стоит думать, что если вы натыкаете все ссылки на какую-то одну страницу и попадете во все топы. Нужно исходить из расчета удобства для пользователя, а не мифическими показателями PageRank. Если мы говорим про белое SEO, то наша задача сделать сайты таким образом, чтобы пользователям и поисковикам было хорошо и позиции сами начнут ползти вверх.

Оптимизация кода сайта

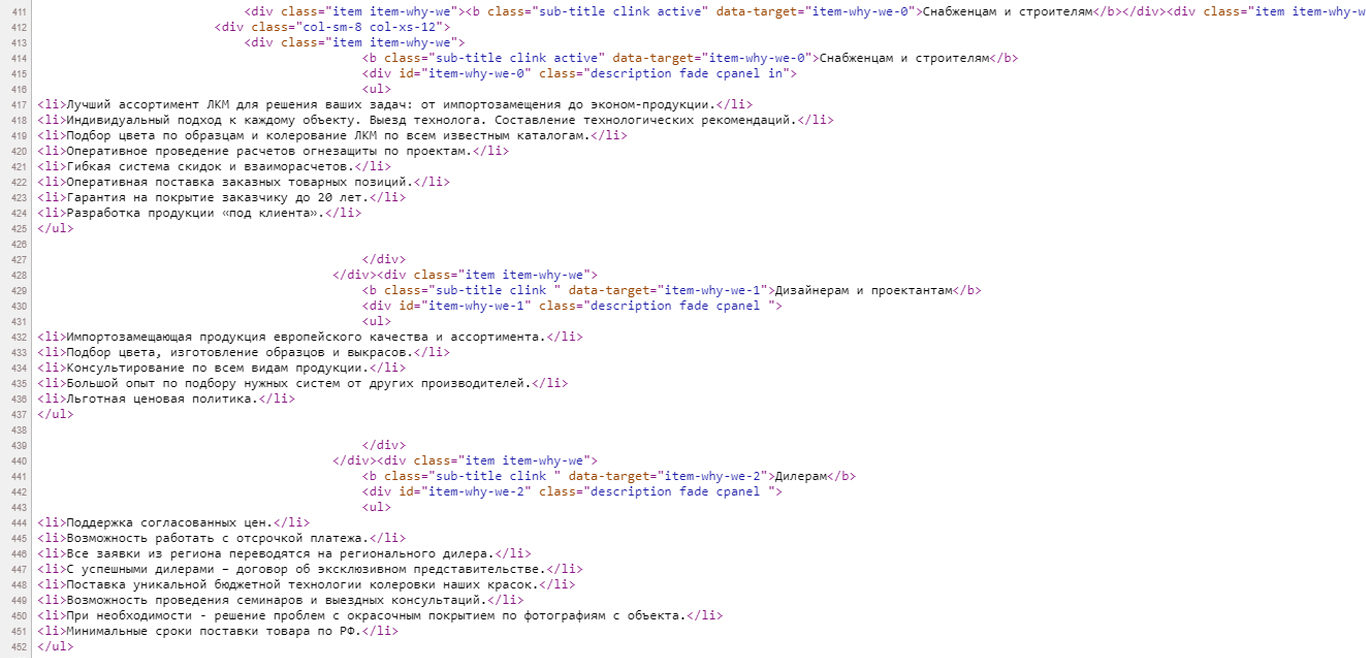

Если вам не повезло и вам сделали сайт без соблюдение культуры разработки и делали так как могли. Скорее всего придется много чего переделывать и долго мучиться. Основная задача на этом этапе пройти все валидаторы html и css кода.

Оптимизация изображений

Файлы изображений не должны быть слишком большого веса (находим оптимальную грань между качеством и весом). Фотографии должны быть подписаны на английском языке с использованием транслита. Название должно отображать содержанием контента. Если у вас словосочетание, то вместо пробела используем «-» (дефис).

Все атрибуты alt должны быть заполнены и отображать суть контента, не стоит перегибать палку и спамить ключевыми запросами.

Сразу хочу сказать, что в большинстве времени, все мы, ищем наиболее простой (дешевый) ответ. Но как показывает практика, хотите много трафика делайте хороший контент и регулярно его обновляйте, а не ищите оптимальное соотношение ключей на квадратный метр текста.

Оптимизация файлов PDF

Если у вас есть на сайте данные типы файлов то их тоже можно оптимизировать. Для этого открываем нужный нам файл и кликаем Файл — Свойства и заполняем:

- Заголовок

- Тема

- Автор

Для внесения данных правок нужно иметь Pro версию редактора!

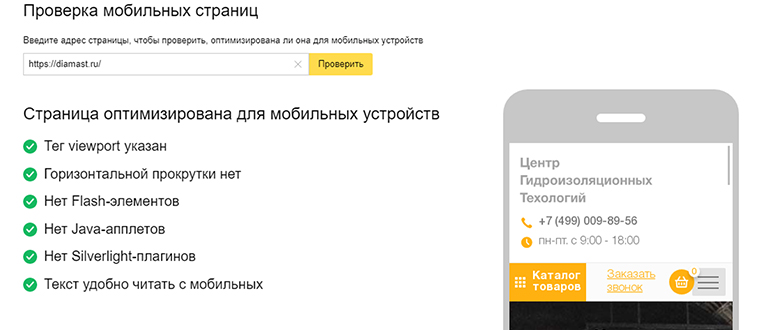

Мобильная версия сайта

Как бы вам не хотелось, но она должна быть. Google скорее всего будет сканировать именно вашу мобильную версию сайт, а не десктопную. Так что нанимаем подрядчика и работаем.

Структура сайта

В данном случае речь идет о семантическом ядре сайта и его разнообразии. Мы хоть и продвигаем отдельные страницы сайта, но нельзя исключать влияние на продвижение и других страниц сайта. Чем больше ответов может дать сайт, тем лучше для всех его страниц.